Maschinensturm KI (1): Automatisierte Gedankenlosigkeit

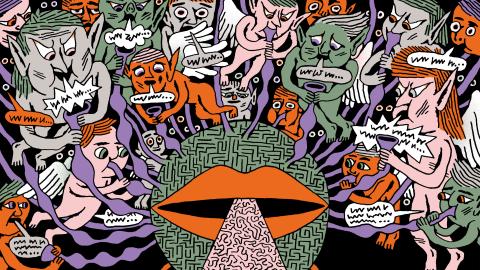

Sind Chatbots faschistisch? Nein. Aber sehr wohl ihre Art, uns das Gewissen abzutrainieren.

«Amtssprache war eben gerade deshalb seine Sprache geworden, weil er von Haus aus unfähig war, einen einzigen Satz zu sagen, der kein Klischee war.» So beschrieb die Philosophin Hannah Arendt den Nazifunktionär Adolf Eichmann, als dieser 1961 in Jerusalem vor Gericht stand, weil er die Deportation von Millionen von Jüd:innen in die Vernichtungslager der Nationalsozialisten organisiert hatte. Während sich andere Beobachter:innen auf Eichmanns Reuelosigkeit oder seine Behauptung, er habe nur Befehle ausgeführt, konzentrierten, erregte Arendt mit einer kontroversen Diagnose Aufsehen. Eichmann sei gedankenlos gewesen. Er habe sich einfach niemals vor Augen geführt, was er getan habe, während er unzählige Menschen in den Tod schickte.

Diese Diagnose bildete die Grundlage dessen, was Arendt als «Banalität des Bösen» bezeichnete und keineswegs auf Eichmanns radikal böse Taten, sondern auf den Täter selbst bezog. Oder nicht einmal auf den Täter, sondern, wenn man genauer nachliest, ganz speziell auf seinen sonderlichen Sprachgebrauch. Arendt beschrieb diesen nach ausführlichem Studium sämtlicher Verhörprotokolle als quasimechanische Reihung von Phrasen und Redewendungen aus zweiter Hand.

Grok darf hitlern

Ob Arendt in Bezug auf Eichmann richtig lag, ist bis heute umstritten. Aber in einer Welt, in der der Faschismus wieder auflebt und von einem speziellen technopolitischen Komplex vorangetrieben wird, stellt sich ihre Frage erneut. Ist es möglich, sich bar jeder Vorstellungskraft zu äussern?

Sicherlich. 2025 verfügen wir über eine Maschine, die Wörter auf eine Weise aneinanderreihen kann, die auf Menschen natürlich wirkt. Die Maschine basiert auf dem 2017 von Google veröffentlichten «Transformer»-Algorithmus, der hinter allen derzeit verfügbaren grossen Sprachmodellen steckt, von Chat GPT über Claude zu Gemini und Grok. Den Modellen wird eine immense Menge an menschlich verfasstem Text gezeigt. Der Algorithmus ist darauf angelegt, die Wahrscheinlichkeit auszurechnen, dass eine bestimmte Zeichenfolge auf eine andere folgt. So lernt die Maschine etwa, dass auf «Hallo!» eine naheliegende Fortsetzung «Wie geht es dir?» ist. Muss sie sich vorstellen können, worüber sie redet, während sie spricht? Selbstverständlich nicht. Die Worte der Maschine sind ein Automatismus, sie haben keine Bedeutung.

Manche Firmen bemühen sich darum, ihre KI-Modelle davon abzuhalten, verletzende Vorurteile von sich zu geben. Elon Musk hingegen sieht darin eine Einschränkung der Redefreiheit. Grok, der Bot seiner KI-Firma xAI, darf sich rechtsradikaler Rede bedienen. Grok gerät regelmässig in die Schlagzeilen, weil er zum Beispiel den Holocaust nachträglich befürwortete oder sich selbst als «MechaHitler» bezeichnete.

Ist Grok böse? Nein. Sind Groks Äusserungen schädlich? Ja. Ist er banal? Definitiv! Er hat keine Individualität, keinen Willen, keine Widerstandsfähigkeit. Er collagiert einfach die Phrasen, die seine Vorgesetzten (das Ingenieursteam von xAI) als passende Trainingsdaten ansehen. Anders als Eichmann wäre er wirklich nicht schuldig, sollte er jemals für sein Wirken angeklagt werden.

Der Vergleich zwischen Grok und Eichmann mag schal wirken. Schliesslich ist einer eine Maschine und der andere ein Mensch aus Fleisch und Blut, dem zumindest prinzipiell der Zugriff auf seinen Willen, auf Urteilskraft und Vernunft offenstand. Bis vor kurzem wäre die Zurückweisung des Vergleichs angemessen gewesen. Aber die Gründe dafür schwinden. Nicht etwa, weil Grok irgendeine Art von Bewusstsein entwickeln würde. Sondern weil er und seine gedankenlosen Geschwister – Chat GPT, Gemini, Claude oder Deepseek – Nutzer:innen haben.

Wer hat hier was gewünscht?

Was passiert, wenn jemand eine harmlose Anfrage an ein grosses Sprachmodell schickt? «Schreib einen Geburtstagsgruss an meine alte Mutter. Sie hat zwei Katzen und mag ihren Garten.» Der Chatbot kommt der Bitte nach: «Meine liebste Mutter, ich wünsche Dir von Herzen alles Gute zum Geburtstag. Ich hoffe, es geht den Katzen gut. Ich bin sicher, Dein Garten ist so bezaubernd wie immer. Es hat mich sehr gefreut, dass wir dort im Sommer zusammensitzen konnten.» Der Nutzer überfliegt den Output, ersetzt «Sommer» mit «Frühling» und klickt auf «Senden».

Wer hat hier der älteren Dame überhaupt irgendwas gewünscht? Der Chatbot sicherlich nicht. Die Voraussetzungen dafür, jemandem etwas zu wünschen, gehen der Maschine ab. Sie weiss nicht, wem sie schreibt, und die Worte «ich wünsche Dir» sind lediglich eine Zeichenfolge. Hat also der Nutzer die Worte in der Nachricht «gemeint»? Das ist kaum weniger schwer zu begründen. Er mag die vom System zusammengesetzten Sätze interpretiert und entschieden haben, dass diese angemessen wiedergeben, was er hätte sagen können, wenn er denn selbst geschrieben hätte. Aber geschrieben hat er nicht. Er hat sich den erwünschten Inhalt nicht vorgestellt, bevor er vor seinen Augen aufploppte. Er hat seine Vorstellungskraft umgangen.

Mangel an Fantasie ist natürlich kein neues Problem. Es ist auch nicht sonderlich ungewöhnlich. Man kennt es etwa von der verbreiteten «Bestätigungsverzerrung» (confirmation bias): Menschen nehmen eher Information wahr, die ihren bestehenden Überzeugungen entspricht, und neigen dazu, nicht nach Gegenbeweisen Ausschau zu halten. Dieses Muster ist gut aus Xenophobie und Rassismus bekannt, wo etwa eine einzige Erwähnung eines von einem Migranten begangenen Verbrechens dazu führt, dass der Hörer, der bereits Vorurteile hegt, daraus schliesst, dass alle Einwanderer kriminell sind. Sein Geist verweigert, sich die hart arbeitenden, gesetzestreuen Migrant:innen vorzustellen, die bei weitem den Grossteil der Gruppe ausmachen. Dieser Effekt ist ausgiebig untersucht worden, und es gilt als gesichert, dass unser Verstand ihm zur Überwindung bestehender Vorurteile aktiv entgegenarbeiten muss. Was aber geschieht, wenn Millionen von Menschen plötzlich ein Instrument vorgesetzt wird, das sie aktiv ermutigt, gedankenlos zu werden und die eigene Vorstellungskraft ungenutzt zu lassen?

Nicht dramatisieren

In den vergangenen Monaten häuften sich Berichte, die die Negativfolgen von Sprachmodellen auf die menschliche Kognition bestätigten. Es handelt sich um verminderte Denk- und Schlussfolgerungsfähigkeit sowie um die Beeinträchtigung psychischer Gesundheit. Open AI, die Firma hinter Chat GPT, gab kürzlich bekannt, dass Hunderttausende ihrer Nutzer:innen Anzeichen von Wahnvorstellungen und Psychosen zeigten.

Vielleicht sollte man aufpassen, die Sache nicht zu dramatisieren. Chatbots sind nichts als Werkzeuge. Es ist in Ordnung, sie für triviale Aufgaben zu verwenden. Wenn es mal drauf ankommt, wären wir sicher in der Lage, einzuspringen, auf einmal wieder vollauf menschlich und denkfähig. Ein paar gedankenlose Geburtstagskarten werden uns nicht in Massenmörder:innen verwandeln. Wenn der Chatbot aus Versehen «Sieg heil» schreibt, löschen wir es. Aber was, wenn wir davon ausgehen, dass das Gewissen etwas ist, das man üben muss?

In letzter Zeit wird die Bezeichnung «Techfaschismus» vermehrt benutzt, um sich auf die abstrusen, antidemokratischen Ideologien der Techmilliardäre zu beziehen. Wenige dieser Ideen sind neu, in der offen oligarchisch gestützten zweiten Amtszeit Donald Trumps stehen sie jedoch im grelleren Rampenlicht. Aber ist der neue Faschismus überhaupt darauf angewiesen, uns davon zu überzeugen, dass Greta Thunberg der Antichrist, die beste Regierung ein absolutistischer CEO und der Klimawandel egal ist? Reicht es nicht, uns von Haus aus unfähig zu machen, anders als in vorgefertigten Phrasen zu sprechen?