Künstliche Intelligenz: Und das Orakel spricht

Die Entwicklung im Bereich der künstlichen Intelligenz schreitet rasant voran und befeuert Hoffnungen wie Zukunftsängste. Höchste Zeit, sich damit auseinanderzusetzen, wie sie funktioniert und wie «intelligent» sie tatsächlich ist.

Sie schalten auf Zuruf das Licht an, bestellen Pizza oder bringen den aktuellen Kontostand in Erfahrung: Smart Speakers wie Alexa von Amazon sollen bis Ende 2018 in einer Million Haushalten weltweit als persönliche Assistenten dienen. Alexa operiert mit künstlicher Intelligenz (KI), weswegen sie Gegenstand einer zunehmend überhitzten Debatte um KI als Segen oder Fluch für die Menschheit wurde. Im Fokus steht der Moment der sogenannten Singularität, der gemäss Technikvisionär und Google-Entwicklungschef Ray Kurzweil 2045 eintreten wird: Superintelligente Maschinen übernehmen die Kontrolle, indem sie sich selbst verbessern und den technologischen Fortschritt so exponentiell beschleunigen.

Der Hype beruht auf einer falschen Vorstellung von künstlicher Intelligenz, die bereits in ihrem Ursprung angelegt ist. Der Begriff stammt vom US-Informatiker John McCarthy, der ihn 1956 an einer Fachkonferenz am Dartmouth College zum ersten Mal verwendete. Er und weitere Mathematiker, Physiker und Ingenieure wollten erforschen, wie «intelligentes menschliches Verhalten» durch Maschinen simuliert werden kann. Diese Definition von KI hält sich bis heute und spiegelt ein technizistisch-mechanistisches Verständnis von Intelligenz: die Gleichsetzung von Computer und Gehirn. Eine Analogie, die in vielerlei Hinsicht nicht nur vereinfachend, sondern falsch ist.

Wir haben nach wie vor keine Ahnung, wie menschliches Bewusstsein entsteht, was es ausmacht und wie genau das Gehirn darin involviert ist. Vieles in der menschlichen Kognition läuft auf einer unbewussten Ebene ab – wir nennen das dann Intuition, Bauchgefühl oder gesunden Menschenverstand. Denken ist etwas fundamental anderes, Komplexeres, als worauf es die KI-Forschung reduziert: einen binären Prozess der Informations- respektive Datenverarbeitung. Die Vorstellung, dass eine Maschine menschliches Bewusstsein, eine allgemeine Intelligenz entwickeln könnte, ist eine Utopie.

Komplexes Modell, simple Prinzipien

Was bislang als künstliche Intelligenz Schlagzeilen gemacht hat – «Deep Blue» schlägt 1996 Schachweltmeister Garri Kasparow, «Alpha Go» bezwingt 2016 den weltbesten Go-Spieler Lee Sedol –, ist eine hoch spezialisierte und extrem eingeschränkte Form von Intelligenz. «Alpha Go» kann nicht Schach spielen, auch wenn seine Rechenleistung die Kapazitäten des menschlichen Gehirns um ein Vielfaches überragt.

Ein KI-System ist ein hochkomplexes mathematisches Modell – und beruht doch auf den simplen Prinzipien der binären Informationsverarbeitung. Analog zum Computer ist auch ein KI-System erst mal ein gigantischer elektronischer Schaltkreis, der durch Strom aktiviert wird. Der zentrale elektrisch leitende Baustein im Computer ist ein Transistor. Sein nichtphysisches Pendant ist ein künstliches Neuron, im Prinzip ein mathematisches Modell, das ein biologisches Neuron nachbilden soll. Beide funktionieren wie ein Schalter, der via Strom auf «on» oder «off» gestellt wird, 1 oder 0, die kleinstmögliche Informationseinheit.

Mittels der Operatoren «und», «oder» und «nicht» lassen sich logische Aussagen bilden. Ein künstliches Neuron fungiert bereits selbst als Logikschalter: Im Unterschied zum Transistor verfügt es über mehrere Eingänge und einen Schwellenwert. Bevor es eine 1 ausgibt, muss der Schwellenwert erreicht sein. Hat ein Neuron zwei Eingänge und den Schwellenwert zwei, müssen beide Eingänge einen Input liefern, es ist also ein «Und»-Schalter. Hat ein Neuron mit zwei Eingängen jedoch den Schwellenwert eins, reicht bereits ein Input aus einem Eingang, es entspricht einem «Oder»-Schalter.

Diese künstlichen Neuronen lassen sich zu einem Netzwerk hocheffizienter Informationsverarbeitung verknüpfen, einem künstlichen neuronalen Netzwerk (KNN). Die Verbindungen zwischen den künstlichen Neuronen sind dabei unterschiedlich gewichtet und lassen sich verändern – auch dies in verkürzter Analogie zum menschlichen Gehirn, bei dem Neuronen stärker miteinander verbunden sind, je häufiger sie miteinander kooperieren. Ein KNN wird nicht durch einen Menschen programmiert, sondern von einem Algorithmus gesteuert, den ein Mensch entwickelt hat. Ein Algorithmus ist eine Handlungsvorschrift respektive ein Verfahren, das einen Problemlösungsprozess automatisiert: Der Algorithmus sucht nach möglichen Lösungen und bewertet diese danach, wie gut sie den Anforderungen entsprechen.

Daten sind das Futter eines Algorithmus. Im besten Fall handelt es sich um strukturierte, also aufbereitete Daten wie Messwerte, Namen, Adressen. Meist jedoch sind die Daten unstrukturiert: Bilder, Filme, Text- oder Sprachdateien. Die Herausforderung besteht also darin, einen Algorithmus so zu programmieren, dass er sie verarbeiten kann. Bilder etwa werden in einzelne Frames unterteilt, die zentrale Wesensmerkmale des abgebildeten Objekts erfassen und kategorisieren sollen: Ein Vogel hat Federn, Flügel, einen Schnabel. Objekte lassen sich nach hierarchischen Kriterien ordnen, «Wenn, dann»-Regeln ermöglichen logische Folgerungen aus Daten. Komplexere Bedeutungszusammenhänge lassen sich etwa mit semantischen Netzwerken erfassen: Hat ein Objekt Federn, Flügel und kann fliegen, dann ist es ein Vogel.

Das Training des Netzwerks

Ein künstliches neuronales Netzwerk lässt sich mithilfe eines Algorithmus so trainieren, dass es in den Daten nicht nur Muster und Regeln erkennt, sondern diese auch für die Klassifizierung neuer Datensätze anwenden kann – und genau hier konzentriert sich der aktuelle Hype um künstliche Intelligenz: beim maschinellen Lernen. Dabei wird unterschieden zwischen überwachtem Lernen, bei dem mittels klassifizierter Datensätze vorgegeben wird, was das System lernen soll, und unüberwachtem Lernen, bei dem das System in den Daten selber nach Mustern und Regeln zur Klassifizierung suchen muss. Im Fall des Verstärkungslernens muss das System aus den Daten sogar ganze Handlungsabläufe erkennen und möglichst erfolgreich zu reproduzieren lernen.

An der Speerspitze von Forschung und Entwicklung in der KI steht das sogenannte Deep Learning. Es basiert auf künstlichen neuronalen Netzwerken, die in Schichten angeordnet sind: Die Eingabeschicht nimmt Daten auf, die Ausgabeschicht gibt das Ergebnis in Form einer Zuordnung bekannt. Dazwischen liegen bis zu weit über hundert weitere Schichten, zwischen denen sich das Lernen vollzieht. Das Netzwerk transformiert dabei die Eingabedaten Schritt für Schritt in Merkmale, mit denen es arbeiten kann. So gelangt es von Pixeln zum Bild, von Buchstaben über Wörter, Wortgruppen und Ausdrücke zum Text oder von Tonsignalen über Phoneme zu gesprochenen Wörtern und ganzen Sätzen. Das Funktionsprinzip der Datenverarbeitung in einem KNN ist selbstorganisiert: Die Gewichtung der Verbindungen zwischen den einzelnen Neuronen ist zu Beginn zufällig verteilt; sie wird erst im Verlauf des Trainings mithilfe eines Algorithmus von Testlauf zu Testlauf angepasst.

Leicht zu manipulieren

Der rasant zunehmenden Komplexität und Leistungsfähigkeit von KNN zum Trotz: Wer glaubt, künstliche Intelligenz nähere sich so «intelligentem menschlichem Verhalten», irrt. Vielmehr gebiert gerade die systematische Überschätzung von KI eine Reihe von Problemen und Gefahren. So ist sie weder rational noch objektiv noch vorurteilslos, auch wenn die binäre Prozessverarbeitung strikt logischen Regeln folgt. Ein Algorithmus widerspiegelt stets die Weltsicht seiner menschlichen EntwicklerInnen. Manche Algorithmen reproduzieren unabsichtlich Stereotype, andere sind mutwillig diskriminierend. Und ihr Funktionieren hängt stärker von der Qualität der Trainingsdaten ab, als den EntwicklerInnen lieb sein kann.

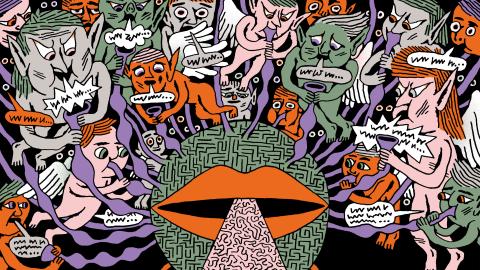

Deep Learning ist in keiner Weise vergleichbar mit menschlichen Denk- und Lernprozessen. Künstliche neuronale Netzwerke funktionieren wie eine Blackbox: Was zwischen der Dateneingabe und dem Ausspucken des Resultats geschieht, ist auch für SpezialistInnen nicht nachvollziehbar. Ein KNN kann Prognosen erstellen – die ihnen zugrunde liegenden Zusammenhänge liefert es nicht. Im antiken Griechenland nannte man das Orakel.

Kommt hinzu, dass man nicht weiss, ob ein KNN überhaupt das lernt, was es sollte. Das US-Militär liess ein Programm entwickeln, das Militärfahrzeuge auf Luftbildern erkennt – was im Training tadellos funktionierte, nicht aber, sobald das System mit neuen Bildern gefüttert wurde. Als Grund dafür entpuppten sich die Trainingsbilder: Aufnahmen ohne Fahrzeuge waren an bewölkten Tagen entstanden, Bilder mit Fahrzeugen bei strahlendem Sonnenschein. Die KI hatte also gelernt, Sonnentage von bewölkten Tagen zu unterscheiden.

Offenbar sind künstliche neuronale Netzwerke auch leicht zu manipulieren: So benötigten Twitter-User 2016 nur wenige Stunden, um den Chatbot Tay von Microsoft in ein rassistisches, Hate Speech verbreitendes Monster zu verwandeln. Und ForscherInnen eines Informatikteams der Universität Bochum haben Ende September öffentlich gemacht, dass es ihnen mühelos gelungen ist, das Spracherkennungssystem von Alexa mit Audiodateien zu hacken, die für das menschliche Gehör nicht wahrnehmbar sind, vom KNN aber erkannt werden. Es wäre also ein Leichtes, Alexa dazu zu bringen, statt Pizza eine Kiste Champagner zu bestellen, vielleicht sogar ein paar Tausender von der Bank auf ein anderes Konto zu überweisen.

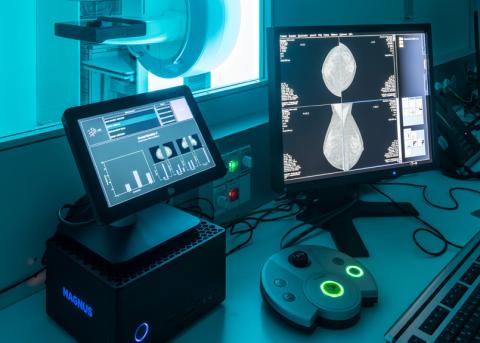

KI-Systeme sind bereits vielerorts im Einsatz: Sie filtern die passende Bewerberin für einen Job heraus, beurteilen, wie kreditwürdig jemand ist, und beeinflussen die Entscheidung, ob ein Straftäter auf Bewährung freikommt oder inhaftiert wird. Das wirft nicht nur enorme ethische Fragen auf. Bedenklich ist auch, wie vorschnell viele Menschen offenbar bereit sind, Kompetenzen, Entscheidungen und Verantwortung an eine Technologie abzutreten, deren «Intelligenz» und Zuverlässigkeit systematisch überschätzt wird.