Digitalisierung: Die Software sagt, wer den Job bekommt

In immer mehr Bereichen fällen nicht länger Menschen aus Fleisch und Blut, sondern Algorithmen Entscheidungen. Der Einsatz sogenannter «Automated Decision Making»-Systeme ist aber alles andere als unproblematisch.

Stellen Sie sich vor: Sie sind auf dem Passbüro, um sich einen neuen Ausweis ausstellen zu lassen. Vor Ort wollen Sie in der Kabine ein biometrisches Foto machen. Doch der hochmoderne Automat erkennt Ihr Gesicht nicht. Es stellt sich heraus: Es ist wegen Ihrer Hautfarbe. So erging es einer Schwarzen Frau im Strassenverkehrsamt Hamburg. Sie wurde Opfer einer Form der automatisierten Diskriminierung durch sogenannte «Automated Decision Making»-Systeme, kurz ADM.

«ADM-System» ist kein fest definierter Begriff. Im Allgemeinen bezeichnet er aber Systeme, in denen menschliche Entscheidungsprozesse in Computerprogramme übersetzt wurden, um sie effizienter zu machen. So wie im Passbüro, wo ein Algorithmus über Beleuchtung und Schärfe entscheidet und abknipst.

Viele ADM-Systeme gehören für uns längst zum Alltag: In Apps berechnen sie uns den schnellsten Weg zum Bahnhof oder entscheiden darüber, ob wir eine Kreditkarte erhalten. Der Einsatzbereich wächst rasant, die Aufgaben werden komplexer und die Wirkungsweise unübersichtlicher: Denn viele ADM-Systeme lernen nach der Entwicklung selber weiter. Von aussen lässt sich oftmals nicht mehr nachvollziehen, wie diese zu ihren Entscheidungen kommen. In vielen Fällen wissen AnwenderInnen nicht einmal, dass sie es mit einem ADM-System zu tun haben – und dass dieses von Diskriminierung und Verzerrung geprägt sein könnte.

Dabei kommt genau das immer wieder und künftig sicher noch häufiger vor. So listet eine Studie aus dem Jahr 2019 der deutschen Antidiskriminierungsstelle 47 Fälle algorithmischer Diskriminierung aus den unterschiedlichsten Bereichen auf: Arbeitsleben, Immobilienmarkt, Kreditwirtschaft, Medizin, Verkehr, Justiz, Polizei, Strafvollzug, Bildung, Verwaltung. Die Folgen dieser Diskriminierung sind besonders gravierend, wo sie Grundrechte verletzen und Menschen keine Ausweichmöglichkeit haben.

Zum Beispiel in der Medizin. Forscherinnen im Bereich der künstlichen Intelligenz und Medizinexperten warnten jüngst in einer Metastudie vor dem überstürzten Gebrauch von Software, die dank selbstlernenden Algorithmen eine Covid-19-Erkrankung erkennen und über die Behandlung entscheiden soll. Die ForscherInnen der Universitäten Cambridge und Manchester zeigten, dass etliche dieser Systeme auf lückenhafte Datensets zurückgreifen – etwa bloss auf Daten von Menschen aus bestimmten Landesteilen und damit sozialen Milieus. Weil jedoch das soziale Umfeld unsere Gesundheit massgeblich beeinflusst, besteht die Gefahr, dass die Erkennungssoftware bei nicht repräsentierten Menschengruppen weniger gut funktioniert und grössere Risiken mit sich bringt.

Schon die Brille macht einen Unterschied

Ob ein ADM-System diskriminierend entscheidet, ist im Einzelfall schwierig zu beweisen. Ein Bereich, der vergleichsweise gut erforscht ist und einen Einblick in die Wirkungsweise von Algorithmen gibt, ist das Personalwesen. Gerade Grosskonzerne, die jährlich Hunderte von Stellen besetzen, versprechen sich effizientere Bewerbungsprozesse und geringere Kosten. Die Schweizer Vermittlungsplattform Job Cloud etwa bietet ein Tool an, das das Internet mittels selbstlernender Algorithmen nach den «passendsten» KandidatInnen durchforstet, bevor eine Stelle überhaupt ausgeschrieben wird.

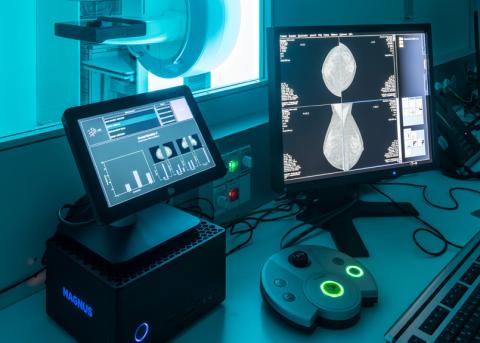

ADM-Systeme suchen aber nicht nur nach geeigneten KandidatInnen, sie führen auch gleich die Bewerbungsgespräche. So hat sich das Münchner Start-up Retorio auf automatisierte Bewerbungsverfahren spezialisiert. Die Firma wirbt auf ihrer Website mit einer Gesichtserkennungssoftware, die «Verhaltensweisen erkennen und darauf basierend ein Persönlichkeitsprofil erstellen» kann. Statt dass BewerberInnen also in einem persönlichen Gespräch das potenzielle Arbeitsumfeld kennenlernen, sprechen sie zu Hause in die Kamera, während ein Algorithmus aus den Antworten bestimmte Persönlichkeitsmerkmale herausliest. Retorio verspricht auf der Website, den Bewerbungsprozess durch die Software «objektiver und fairer» zu gestalten und «ausgeglichene Resultate» zu liefern. Das System betrachte «Menschen unabhängig von ihrer Hautfarbe, ihrem Geschlecht oder ihrem Alter».

Recherchen des Bayrischen Rundfunks haben jedoch offengelegt, wie undurchsichtig und verwirrlich die Software von Retorio Entscheidungen fällt. Dazu testeten die JournalistInnen die Bewerbungssoftware mit SchauspielerInnen, die vor der Kamera unterschiedliche Kleidung trugen. Das Resultat: Bereits minimale Veränderungen beeinflussen die Einschätzungen der Software enorm. So führte das Tragen einer Brille oder einer Kopfbedeckung zu einem völlig neuen Ergebnis, selbst wenn die Schauspielerin den gleichen Text im gleichen Tonfall sprach. Auch irrelevante Details veränderten die automatisch berechneten Bewertungen – so wurden Personen als «offener» und «gewissenhafter» eingeschätzt, wenn im Hintergrund ein Bild hing oder ein Bücherregal stand.

Was Retorio und ähnliche Unternehmen mit ihrem auf Inklusion und Fairness bedachten PR-Sprech verschleiern: Emotionen oder Charaktereigenschaften lassen sich über den Gesichtsausdruck nicht zuverlässig erkennen. «Die Art und Weise, wie Menschen Wut, Ekel, Angst, Freude, Traurigkeit und Überraschung kommunizieren, variiert erheblich zwischen verschiedenen Kulturen, Situationen und sogar zwischen verschiedenen Personen innerhalb derselben Situation», schreibt ein Team der Northeastern University und des Massachusetts General Hospital. Die Neurowissenschaftlerin Lisa Feldman Barrett geht in einem Interview mit der «MIT Technology Review» noch weiter: «Ich kenne keine Technologie, die Emotionen aus den Gesichtern oder Stimmen von Menschen ablesen kann.»

Gerade Gesichtserkennungssoftware, wie sie Retorio einsetzt, gilt gemeinhin als anfällig für Diskriminierung und Verzerrung. So zeigte etwa die Informatikerin Joy Buolamwini, dass gängige Systeme Frauen und People of Color deutlich schlechter erkennen als weisse Männer. Dies hat massgeblich damit zu tun, dass diese primär mit Bildern von weissen Männern trainiert wurden. In Europa will der NGO-Zusammenschluss European Digital Rights solche Software verbieten. Damit soll verhindert werden, dass diese besonders heiklen ADM-Systeme flächendeckend eingesetzt werden, bevor ihre Folgen genügend erforscht, rechtliche Rahmenbedingungen geschaffen und ethische Prinzipien fest in der Entwicklung verankert sind.

Was heisst hier überhaupt «fair»?

«Algorithmen beizubringen, fair zu entscheiden, ist eine riesige Herausforderung. Hier müssen verschiedene wissenschaftliche Disziplinen eng zusammenarbeiten», sagt Lea Strohm vom Zürcher Beratungsbüro für Innovationsethik Ethix. Die Sozialwissenschaftlerin unterstützt Firmen dabei, die von ihnen angewandte Software auf mögliche Diskriminierungen zu überprüfen und ethischer zu gestalten. Mit ihrer Arbeit will sie dabei helfen, dass alle Beteiligten – vom Planungsteam über die Entwicklerin bis zum Endnutzer – überhaupt dasselbe meinen, wenn sie von «Fairness» sprechen.

Dabei will Strohm die unterschiedlichen Vorstellungen auf einen gemeinsamen Nenner bringen, Transparenz schaffen und fragen: «An welchen Werten richten wir uns gerade aus? An liberal-demokratischen Werten? An den Menschenrechten? Spielen moralische Vorstellungen eine Rolle?» Sie vermittelt auch zwischen den verschiedenen Begriffen, die hier zusammenkommen: «Diskriminierung etwa kann sehr Unterschiedliches bedeuten», sagt Strohm. «In der Informatik bedeutet es zunächst bloss, bestimmte Teile eines Datensatzes anders zu behandeln. In den Sozialwissenschaften verstehen wir aber unter Diskriminierung die ungerechtfertigte Ungleichbehandlung von bestimmten Personen und Gruppen.»

Zu seltsamen Vorstellungen über die Funktionsweise von ADM-Systemen trägt nicht zuletzt die mediale Berichterstattung bei. «Künstliche Intelligenz scheint Bücherregale zu mögen», schrieb ein IT-Magazin salopp über den Fall Retorio. So wird suggeriert, ein Algorithmus habe selbst eine Meinung – was natürlich nicht stimmt, denn ein Algorithmus «mag» überhaupt nichts. Er sucht bloss nach Mustern in einem Datensatz, etwa nach Gesichtern mit offenem Mund. Wertend wird der Algorithmus erst dadurch, dass ein Mensch der Software vorgibt, dass ein Lachen eine glückliche Person bedeutet. «Code beruht immer auf den Entscheidungen der Entwicklerinnen», sagt Strohm. «Und diese Entscheidungen sind bewusst und unbewusst von Werten und Erfahrungen geprägt.»

Der menschliche Blick

Selbst ein «fairer» Code bedeutet noch lange nicht, dass der Algorithmus keine Vorurteile reproduziert. Häufig liegt die Ursache für Diskriminierung im Datenset, mit dem ADM-Systeme trainiert werden. Damit soll sich der Algorithmus auf seine Aufgabe spezialisieren. Sind die verwendeten Daten lückenhaft oder falsch, entwickelt er entsprechend verzerrte Muster.

Retorio hat seine Bewerbungssoftware nach eigenen Angaben mit einem Datenset gefüttert, für das sich 2500 Menschen 12 000 Videos angeschaut und die darin gezeigten Personen nach bestimmten Persönlichkeitsmerkmalen wie «Offenheit» oder «Gewissenhaftigkeit» beurteilt hatten. Damit wird bereits im Datensatz der menschliche Blick festgehalten. Dieser ist jedoch weder frei von expliziten und impliziten Vorurteilen, noch lassen sich diese Vorurteile mit möglichst grossen Samples zum Verschwinden bringen.

Oft beginnt Diskriminierung noch früher. Nicht über alle Personengruppen existieren gleich viele Daten. So belegt die britische Journalistin Caroline Criado-Perez in ihrem Buch «Unsichtbare Frauen», wie Frauen in Statistiken und Datensammlungen unterrepräsentiert sind oder falsch interpretiert werden – kurz: wie gross der «Gender Data Gap» ist (siehe WOZ Nr. 20/2020 ). Ein Beispiel: Die Behörden einer schwedischen Stadt stellten fest, dass Frauen bei Schneeräumungsarbeiten systematisch benachteiligt werden. Zuerst befreite man nämlich Hauptstrassen von Schnee, was vor allem Männern zugutekam, weil die öfters mit dem Auto unterwegs sind. Derweil führten die ungeräumten Quartierstrassen zu mehr Unfällen bei Frauen, die mehrheitlich Care-Arbeit verrichten und zum Beispiel mit dem Kinderwagen unterwegs waren.

Je umfassender also Arbeitsabläufe automatisiert werden, desto schwieriger lässt sich nachweisen, dass überhaupt systematisch Entscheidungen getroffen werden, die bestimmte Personen benachteiligen, und wo der Ursprung dieser Diskriminierung liegt. Auch die rasante technische Entwicklung und weit verbreitete Intransparenz gestalten eine Übersicht schwierig. Der Ruf nach rechtlicher und politischer Regulierung wird daher lauter. Doch die europäische Datenschutzgrundverordnung (DSGVO) verbietet lediglich vollständig automatisierte Entscheidungen durch Algorithmen, wenn dies die Betroffenen erheblich beeinträchtigt. Zum Beispiel darf ein Algorithmus nicht alleine über Kredite, Jobs oder Haftstrafen entscheiden. In der aktuell laufenden Revision des Schweizer Datenschutzgesetzes fehlt sogar diese Einschränkung. So werden der Anwendung von ADM-Systemen kaum Hürden gesetzt.

Zwar geben sich viele Unternehmen mittlerweile selber Richtlinien in der Form von Ethikprinzipien. Aber wie das Beispiel Retorio zeigt: Zu bedeuten hat das noch nichts.

Wie ADM-Systeme lernen

Automatisierte Entscheidungssysteme sollen ein bestimmtes Problem lösen, zum Beispiel die passendste Person für eine Stelle finden. Dafür müssen EntwicklerInnen definieren, nach welchen Merkmalen der Algorithmus entscheiden soll. Sind Wohnort, Nationalität, Geschlecht oder Alter relevant? Manche ADM-Systeme werden dann nach expliziten Regeln in der Form von Entscheidungsbäumen programmiert.

Oft wird der Algorithmus aber durch maschinelles Lernen mit grossen Datenmengen trainiert. Hier erkennt der Algorithmus selber Korrelationen und bestimmt selbstständig Zusammenhänge, die dann die Entscheidung anleiten. Wurden in der Vergangenheit etwa überwiegend Männer eingestellt, leitet der Algorithmus daraus vielleicht ab, dass Männer besser für die Stelle geeignet seien. So reproduzieren ADM-Systeme oft bereits sozial etablierte Ungleichbehandlungen.